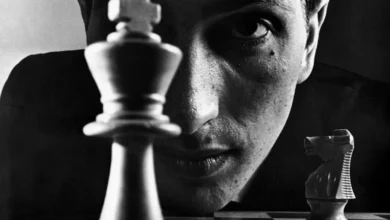

نابغه هوش مصنوعی آمریکا در چین چه میکند؟

نابغه هوش مصنوعی آمریکا در چین چه میکند؟

مرتد دره سیلیکون: نبردی بر سر روح هوش مصنوعی

در اوایل دهه ۲۰۰۰، دو مکتب فکری اصلی برای ساختن ماشینهای هوشمند وجود داشت. یکی از آنها، که توسط چهرههایی مانند جفری هینتون و یان لیکان رهبری میشد، بر «شبکههای عصبی» تمرکز داشت؛ سیستمهای ریاضی که با الهام از مغز انسان، از طریق تحلیل حجم عظیمی از دادهها یاد میگیرند.

اعضای مکتب دیگر یعنی «هاروارد-براون»، نامی که ژو به تیمش داده بود، بینایی را به عنوان یک مسئلهی آماری میدیدند و به روشهایی مانند «استنتاج بیزی» و «میدانهای تصادفی مارکوف» تکیه میکردند.

او معتقد بود ماشینها باید بتوانند با کمترین داده استدلال کنند، نه فقط الگوهای میلیونها تصویر را تقلید کنند

این دو مکتب به زبانهای ریاضی متفاوتی صحبت میکردند و اختلافنظرهای فلسفی داشتند. اما در یک منطق زیربنایی مشترک بودند که امروزه در سیستمهای هوش مصنوعی مانند ChatGPT وجود دارد: اینکه دادهها، و نه دستورالعملهای دستی، میتوانند زیرساخت لازم برای درک جهان و بازتولید الگوهای آن توسط ماشینها را فراهم کنند.

springer nature

برای مدتی، این دو مکتب بهموازات هم پیش میرفتند. ژو حتی برای حل مشکل کمبود داده، یک مؤسسه تحقیقاتی به نام «لوتوس هیل» در زادگاهش در چین تأسیس کرد تا تصاویر را برای آموزش مدلهای هوش مصنوعی برچسبگذاری کنند. اما حوالی سال ۲۰۰۹، ژو به این نتیجه رسید که این رویکرد به بنبست رسیده است. او معتقد بود هوش واقعی، توانایی استدلال و حل مسئله با حداقل اطلاعات ورودی است، نه فقط تشخیص الگو در میلیونها تصویر.

او میگفت: «اگر یک ماشین را با هزاران کتاب آموزش دهید، شاید یاد بگیرد مردم چگونه صحبت میکنند، اما آیا میفهمد چرا ما آن کلمات را به زبان میآوریم؟». نه، لایهی عمیقتری از شناخت وجود نداشت. او مؤسسه لوتوس هیل را تعطیل نمود و مسیر خود را جدا کرد. به دنبال ساختن عاملهایی با یک «معماری شناختی» رفت که قادر به استدلال، برنامهریزی و تکامل در بافتهای فیزیکی و اجتماعی خود تنها با مقادیر اندکی از دادهها باشند.

از نگاه ژو، شبکههای عصبی جعبههای سیاهی بودند که هیچکس دلیل عملکردشان را نمیدانست

شاید این تصمیم را در بدترین زمان ممکن گرفته شد؛ زیرا تقریباً در همان دوران، یک مجموعهداده عظیم به نام ImageNet منتشر شد که انقلابی در حوزه هوش مصنوعی ایجاد کرد. سال ۲۰۱۲، یک شبکه عصبی که توسط تیم جفری هینتون توسعهیافته بود، با استفاده از ImageNet به موفقیتی خیرهکننده دستیافت و برتری مطلق رویکرد «دادههای بزرگ» را تثبیت کرد.

همین پیروزی، موج جهانی هوش مصنوعی را به راه انداخت که تا امروز ادامه دارد. ژو بعدها در نامهای به استادش نوشت: «درست زمانی که من به دادههای بزرگ پشت کردم، منفجر شد.»

شکاف بین ژو و جریان اصلی عمیقتر شد. او شبکههای عصبی را به دلیل ماهیت «جعبه سیاه» آنها نقد میکرد. بله، آنها عملکرد خوبی دارند، اما هیچکس دقیقاً نمیداند چرا و چگونه به نتیجه میرسند. این رویکرد به نظر او سطحی و فاقد بنیان نظری محکم بود.

از دید ژو، این امر فرهنگ ازخودراضی بودن و یک ذهنیت «عملکرد به هر قیمت» را ترویج داده است. او معتقد است یک سیستم بهتر باید ساختارمندتر و پاسخگوتر باشد. یا خود سیستم یا خالق آن باید بتواند پاسخهایش را توضیح دهد.

پیشگامان شبکههای عصبی راهشان را به شرکتهای بزرگ باز کردند: هینتون به گوگل پیوست، لوکان به متا رفت و ایلیا سوتسکور، یکی از نویسندگان شبکهی عصبی برنده در ایمیجنت، به تأسیس OpenAI کمک کرد.

در سال ۲۰۱۸، هینتون و لوکان به همراه بنجیو، جایزهی تورینگ معتبرترین جایزهی علوم کامپیوتر را برای کارشان بر روی شبکههای عصبی دریافت کردند. در سال ۲۰۲۴، هینتون بهطور مشترک برندهی جایزهی نوبل فیزیک شد؛ به پاس «اکتشافات و نوآوریهای بنیادینی که زمینهساز یادگیری ماشین با شبکههای عصبی مصنوعی شدند.»

ژو باور داشت هوش مصنوعی باید ساختاری شفاف و پاسخگو داشته باشد، نه اینکه صرفاً نتایجی بیتوضیح ارائه دهد

در همین حال ژو به مسیری تنها و منزوی قدم گذاشت. او در آزمایشگاهش کار روی معماری شناختی را ادامه داد و دانشجویانش را از بهکاربردن کلماتی مانند «یادگیری عمیق» یا «شبکه عصبی» منع میکرد. او باوری تزلزلناپذیر به دیدگاه خود داشت، حتی اگر تمام دنیا در جهت مخالف حرکت میکرد.

فشار از دو سو: وقتی علم و سیاست در هم میآمیزند

منبع : زومیت